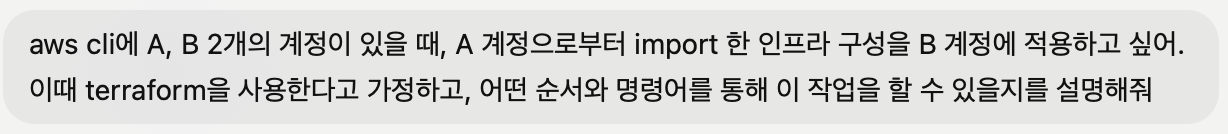

이제는 과제를 해보자. 슬라이드 뒤편에 과제 슬라이드를 첨부해 주셨으니 하나씩 읽으면서 해 보자.

✅ 과제 #1: 이해하기

슬라이드를 직접 캡처하기가 애매해서 말로 풀어서 써보겠다.

과제 #1에서는 테이블을 만들 때 '코멘트'를 넣는 작업을 하면 된다. 정확히는 django ORM에서 Model의 verbose_name, Field의 verbose_name 값으로 입력한 값이 필드의 '코멘트'가 되도록 하는 작업이다.

사실 나는 '코멘트'가 뭔지 잘 몰랐다. 블로그 글을 보면서 이해한 바로는 '코멘트'는 SQL(mysql, oracle 등) db에서 제공하는 하나의 기능으로, 필드나 테이블의 의미를 나타내기 위한 기능이라고 한다.

아래는 oracle db에서 코멘트를 추가하는 문법이다.

COMMENT ON TABLE 테이블명 IS '코멘트 내용';

COMMENT ON COLUMN 테이블명.컬럼명 IS '코멘트 내용';

어쨌든, 이를 알았으니 과제를 이해해볼 수 있겠다. 내가 알기로는 기본적으로 django model, field에서 있는 verbose_name 값은 db의 comment와 아무런 관계가 없는 것이 기본값이다.

관계를 만들고 싶다면 아마도 DatabaseSchemaEditor를 사용해야 한다고 이해했다. 과제에서 원하는 것은 verbose_name 속성이 create, update, delete 될 때 db의 comment도 같이 업데이트 되는 것이다. verbose_name 속성은 필드나 테이블의 속성을 수정하는 것이므로 migration의 영역이지 queryset의 영역은 아니다.

그리고 일반 migration에서는 이러한 기능을 제공하지 않는다. 정확히 말하면 migration에서도 SQL.runpython(정확한 명령이 맞나 모르겠다)로 raw SQL을 실행시킬 수 있지만, 이러면 매번 필드나 테이블을 변경할 때마다 raw SQL 쿼리를 짜야 한다. 비효율적이라는 말이겠다.

그러므로 그 밑단에 있는 DatabaseSchemaEditor의 기능을 재정의하거나 일부 수정해서, 다음과 같은 일들을 하게 하면 되겠다.

- create table/column 작업 시 verbose_name 속성이 있다면 comment 추가하기

- update table/column 작업 시 verbose_name 속성이 수정/삭제되었다면 comment 수정하거나 삭제하기

그렇다면 DatabaseSchemaEditor의 source code를 봐 보자.

보려고 했는데 source code가 2000줄이 넘는다... 일단은 문서를 보고 이해가 안 되면 코드를 보자. 다행히 이럴 줄 알았는지 SchemaEditor 문서에는 메소드들이 잘 설명되어 있었다. 여기서 필드나 모델을 생성하는 경우, 지우는 경우(지우려는 field나 table에 comment가 있다면 지워야 하므로), 수정하는 경우에 대한 메소드들만 정리해 보았다.

- create_model

- delete_model

- alter_db_table_comment

- add_field

- remove_field

- alter_field

한 가지 의문은 왜 table의 경우 'alter_db_table_comment' 메소드가 따로 있는데 필드의 경우는 없는지 모르겠다. 정 없으면 alter_field 메소드에서 작업을 대신하면 되니 일단 넘어가자.

그 다음에 할 일은 이 메소드들의 소스 코드만 보고, 작업을 아주 대략적으로 이해하는 것이다. 우선 'create_model' 메소드를 봐 봤다. table_sql이란 다른 메소드를 통해 실행할 SQL을 받아온 다음, 추가적인 작업을 더 하는 것으로 보였다. 그 중에서도 중요한 부분은 db_comment와 관련된 이 부분이었다.

class BaseDatabaseSchemaEditor:

def create_model(self, model):

"""

Create a table and any accompanying indexes or unique constraints for

the given `model`.

"""

sql, params = self.table_sql(model)

# Prevent using [] as params, in the case a literal '%' is used in the

# definition on backends that don't support parametrized DDL.

self.execute(sql, params or None)

if self.connection.features.supports_comments:

# Add table comment.

if model._meta.db_table_comment:

self.alter_db_table_comment(model, None, model._meta.db_table_comment)

# Add column comments.

if not self.connection.features.supports_comments_inline:

for field in model._meta.local_fields:

if field.db_comment:

field_db_params = field.db_parameters(

connection=self.connection

)

field_type = field_db_params["type"]

self.execute(

*self._alter_column_comment_sql(

model, field, field_type, field.db_comment

)

)

# Add any field index (deferred as SQLite _remake_table needs it).

self.deferred_sql.extend(self._model_indexes_sql(model))

# Make M2M tables

for field in model._meta.local_many_to_many:

if field.remote_field.through._meta.auto_created:

self.create_model(field.remote_field.through)

한 메소드만 가져와봤는데도 길다... 암튼 여기서 중요한 부분은 'alter_db_table_comment'와 'if field.db_comment' 부분이다. 이 부분에서는 각각 table comment와 column comment를 더해준다는 주석이 적혀있어서 금방 알아볼 수 있었다.

그럼 이 부분을 override 해 주면 되겠다. 그런데 migration 수정은 해 봤어도 DatabaseSchemaEditor 수정은 처음 해 본다. 이 부분은 잘 모르겠어서 GPT 찬스를 써 봤다.

크게 세 단계를 거치면 되었다.

- BaseDatabaseSchemaEditor를 상속받는 새 DatabaseSchemaEditor 클래스를 작성한다.

- 각 DB(여기서는 SQLite)의 DatabaseWrapper 클래스를 상속받아서 1번에서 정의한 새 SchemaEditor를 사용함을 선언한다.

- 1번과 2번 파일이 들어있는 모듈을 만들고, 1번은 schema.py에, 2번은 base.py 파일에 위치시킨다.

- settings.py의 DATABASES 변수 값 안의 'engine' 속성을 3번의 프로젝트 상대 경로로 지정한다.

그럼 이제 이 방식대로 코딩을 해 보자.

우선 1번, 새 DatabaseSchemaEditor 클래스를 작성해 보자. 관건은 어떻게 하면 '적은 코드를 바꿔서 comment를 수정하도록 할 것인가'였다. 이를 위해서 'comment'로 전체검색을 해 보았다. 그랬더니 다음과 같은 코드가 나오는 게 아닌가.

sql_alter_table_comment = "COMMENT ON TABLE %(table)s IS %(comment)s"

sql_alter_column_comment = "COMMENT ON COLUMN %(table)s.%(column)s IS %(comment)s"

이 변수들을 사용하는 코드를 찾아보았다. alter_table_comment 변수는 alter_db_table_comment에서 사용하고 있었다. 그리고 이 alter_db_table_comment는 create_model 메소드에서 호출되고 있었다. 그렇다면 모델을 만들 때 외에는 comment를 별도로 업데이트하지 않는 것인가? 일단 이 의문을 갖고 넘어가 보자.

def alter_db_table_comment(self, model, old_db_table_comment, new_db_table_comment):

if self.sql_alter_table_comment and self.connection.features.supports_comments:

self.execute(

self.sql_alter_table_comment

% {

"table": self.quote_name(model._meta.db_table),

"comment": self.quote_value(new_db_table_comment or ""),

}

)

이번에는 sql_alter_column_comment 변수의 사용처를 찾아보았다. _alter_column_comment_sql에서 사용되고 있었고, 해당 함수는 create_model, add_field, _alter_column_type_sql 함수에서 사용되고 있었다. _alter_column_type_sql에서 사용된 것은 의외였다. column type을 바꾸는 데 comment가 관여할 여지가 있나 의문이다.

def _alter_column_comment_sql(self, model, new_field, new_type, new_db_comment):

return (

self.sql_alter_column_comment

% {

"table": self.quote_name(model._meta.db_table),

"column": self.quote_name(new_field.column),

"comment": self._comment_sql(new_db_comment),

},

[],

)

여기서 왜 코멘트 관련 문법이 이렇게 간단하지 싶었는데, 알고보니 코멘트의 create, update, delete 문법이 모두 같았다. 그래서 위의 두 가지 sql문으로 모두 커버가 되는 것이었다. 그러면 이제는 위에서 언급된, comment 관련 필드를 사용하는 메소드를 override 해 주면 되겠다.

- create_model

- add_field

- _alter_column_type_sql

✅ 과제 #1: 결과물

세 개의 메소드를 재정의하였고, 주 변경 내용은 필드를 바꾼 것이었다. 예를 들면 기존의 table._meta.db_comment로 되어있는 변수 대신 table._meta.verbose_name으로 바꿔 주는 작업이 주였다. 구현해 본 코드는 다음과 같다. (구현한 부분에다가만 주석을 달아보았다)

# custom_engine/schema.py

from django.db.backends.mysql.schema import DatabaseSchemaEditor

from django.db.backends.utils import split_identifier

from django.db.models import NOT_PROVIDED

class CustomDatabaseSchemaEditor(DatabaseSchemaEditor):

def create_model(self, model):

"""

Create a table and any accompanying indexes or unique constraints for

the given `model`.

"""

sql, params = self.table_sql(model)

# Prevent using [] as params, in the case a literal '%' is used in the

# definition on backends that don't support parametrized DDL.

self.execute(sql, params or None)

if self.connection.features.supports_comments:

"""

추가한 부분 - 'db_table_comment' 대신 'verbose_name' 사용

"""

if model._meta.verbose_name:

self.alter_db_table_comment(model, None, model._meta.verbose_name)

if model._meta.db_table_comment:

self.alter_db_table_comment(model, None, model._meta.db_table_comment)

"""

추가한 부분 - 'db_table_comment' 대신 'verbose_name' 사용

"""

if not self.connection.features.supports_comments_inline:

for field in model._meta.local_fields:

if field.verbose_name:

field_db_params = field.db_parameters(

connection = self.connection

)

field_type = field_db_params["type"]

self.execute(

*self._alter_column_comment_sql(

model, field, field_type, field.verbose_name

)

)

# Add column comments.

if not self.connection.features.supports_comments_inline:

for field in model._meta.local_fields:

if field.db_comment:

field_db_params = field.db_parameters(

connection=self.connection

)

field_type = field_db_params["type"]

self.execute(

*self._alter_column_comment_sql(

model, field, field_type, field.db_comment

)

)

# Add any field index (deferred as SQLite _remake_table needs it).

self.deferred_sql.extend(self._model_indexes_sql(model))

# Make M2M tables

for field in model._meta.local_many_to_many:

if field.remote_field.through._meta.auto_created:

self.create_model(field.remote_field.through)

def add_field(self, model, field):

"""

Create a field on a model. Usually involves adding a column, but may

involve adding a table instead (for M2M fields).

"""

# Special-case implicit M2M tables

if field.many_to_many and field.remote_field.through._meta.auto_created:

return self.create_model(field.remote_field.through)

# Get the column's definition

definition, params = self.column_sql(model, field, include_default=True)

# It might not actually have a column behind it

if definition is None:

return

if col_type_suffix := field.db_type_suffix(connection=self.connection):

definition += f" {col_type_suffix}"

# Check constraints can go on the column SQL here

db_params = field.db_parameters(connection=self.connection)

if db_params["check"]:

definition += " " + self.sql_check_constraint % db_params

if (

field.remote_field

and self.connection.features.supports_foreign_keys

and field.db_constraint

):

constraint_suffix = "_fk_%(to_table)s_%(to_column)s"

# Add FK constraint inline, if supported.

if self.sql_create_column_inline_fk:

to_table = field.remote_field.model._meta.db_table

to_column = field.remote_field.model._meta.get_field(

field.remote_field.field_name

).column

namespace, _ = split_identifier(model._meta.db_table)

definition += " " + self.sql_create_column_inline_fk % {

"name": self._fk_constraint_name(model, field, constraint_suffix),

"namespace": (

"%s." % self.quote_name(namespace) if namespace else ""

),

"column": self.quote_name(field.column),

"to_table": self.quote_name(to_table),

"to_column": self.quote_name(to_column),

"deferrable": self.connection.ops.deferrable_sql(),

}

# Otherwise, add FK constraints later.

else:

self.deferred_sql.append(

self._create_fk_sql(model, field, constraint_suffix)

)

# Build the SQL and run it

sql = self.sql_create_column % {

"table": self.quote_name(model._meta.db_table),

"column": self.quote_name(field.column),

"definition": definition,

}

# Prevent using [] as params, in the case a literal '%' is used in the

# definition on backends that don't support parametrized DDL.

self.execute(sql, params or None)

# Drop the default if we need to

if (

field.db_default is NOT_PROVIDED

and not self.skip_default_on_alter(field)

and self.effective_default(field) is not None

):

changes_sql, params = self._alter_column_default_sql(

model, None, field, drop=True

)

sql = self.sql_alter_column % {

"table": self.quote_name(model._meta.db_table),

"changes": changes_sql,

}

self.execute(sql, params)

"""

추가한 부분 - 'db_table_comment' 대신 'verbose_name' 사용

"""

if (

field.verbose_name

and self.connection.features.supports_comments

and not self.connection.features.supports_comments_inline

):

field_type = db_params["type"]

self.execute(

*self._alter_column_comment_sql(

model, field, field_type, field.verbose_name

)

)

# Add field comment, if required.

if (

field.db_comment

and self.connection.features.supports_comments

and not self.connection.features.supports_comments_inline

):

field_type = db_params["type"]

self.execute(

*self._alter_column_comment_sql(

model, field, field_type, field.db_comment

)

)

# Add an index, if required

self.deferred_sql.extend(self._field_indexes_sql(model, field))

# Reset connection if required

if self.connection.features.connection_persists_old_columns:

self.connection.close()

def _alter_column_type_sql(

self, model, old_field, new_field, new_type, old_collation, new_collation

):

"""

Hook to specialize column type alteration for different backends,

for cases when a creation type is different to an alteration type

(e.g. SERIAL in PostgreSQL, PostGIS fields).

Return a 2-tuple of: an SQL fragment of (sql, params) to insert into

an ALTER TABLE statement and a list of extra (sql, params) tuples to

run once the field is altered.

"""

other_actions = []

if collate_sql := self._collate_sql(

new_collation, old_collation, model._meta.db_table

):

collate_sql = f" {collate_sql}"

else:

collate_sql = ""

"""

추가한 부분 - 'db_table_comment' 대신 'verbose_name' 사용

"""

comment_sql = ""

if self.connection.features.supports_comments and not new_field.many_to_many:

if old_field.verbose_name != new_field.verbose_name:

sql, params = self._alter_column_comment_sql(

model, new_field, new_type, new_field.verbose_name

)

if sql:

other_actions.append((sql, params))

# Comment change?

if self.connection.features.supports_comments and not new_field.many_to_many:

comment_sql = ""

if old_field.db_comment != new_field.db_comment:

# PostgreSQL and Oracle can't execute 'ALTER COLUMN ...' and

# 'COMMENT ON ...' at the same time.

sql, params = self._alter_column_comment_sql(

model, new_field, new_type, new_field.db_comment

)

if sql:

other_actions.append((sql, params))

if new_field.db_comment:

comment_sql = self._comment_sql(new_field.db_comment)

return (

(

self.sql_alter_column_type

% {

"column": self.quote_name(new_field.column),

"type": new_type,

"collation": collate_sql,

"comment": comment_sql,

},

[],

),

other_actions,

)

이렇게 구현해 보고, 2번 과정인 DatabaseWrapper 클래스를 선언해 주었다.

# custom_engine/base.py

from custom_engine.schema import CustomDatabaseSchemaEditor

from django.db.backends.sqlite3.base import DatabaseWrapper as SQLite3DatabaseWrapper

class CustomSQLite3DatabaseWrapper(SQLite3DatabaseWrapper):

SchemaEditorClass = CustomDatabaseSchemaEditor

이제는 settings.py의 DATABASES 속성에서 engine의 값을 바꿔보자.

# settings.py

DATABASES = {

"default": {

"ENGINE": "orm.custom_engine",

"NAME": BASE_DIR / "db.sqlite3",

}

}

이렇게 해 주면 과제의 1차 설정은 끝났다. 이제는 과제를 구현한 대로 잘 되는지를 확인해 보자.

추가적인 질의를 통해 알게 된 사실인데 Sqlite는 comment 기능이 없다고 한다... 큰일날 뻔했다. comment 기능을 확인하려면 database를 바꿔 주어야 하겠다. 로컬에 설정되어 있는 mysql db로 일단 바꿔주었다.

# settings.py

DATABASES = {

"default": {

"ENGINE": "custom_engine",

"NAME": "django_orm_tutorial",

"USER": "myuser",

"PASSWORD": "mypassword",

"HOST": "127.0.0.1",

"PORT": "3306",

}

}

DatabaseWrapper 클래스도 mysql의 DatabaseWrapper를 사용하도록 바꿔주었다.

# custom_engine/base.py

from django.db.backends.mysql.base import DatabaseWrapper

from .schema import CustomDatabaseSchemaEditor

class CustomMysqlDatabaseWrapper(DatabaseWrapper):

SchemaEditorClass = CustomDatabaseSchemaEditor

잘 동작하는지까지 확인하였다. 이제 해야 할 일은 다음과 같다.

- 새 모델 생성하고, verbose_name 값을 설정하기

- python manage.py makemigrations && python manage.py migrate

- mysql db에 들어가서 해당 모델의 comment 속성이 잘 추가되었는지 확인하기

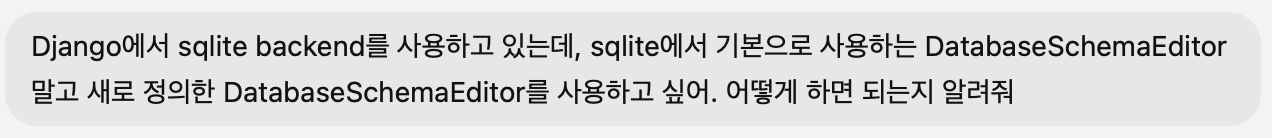

그리고 이 방법을 따랐다... 그런데 추가가 되지 않았다..!!

무슨 일일까. 우선 아래의 명령어를 사용하면 table에 생성된 comment를 볼 수 있다고 해서 그대로 따라해 보았다.

SELECT

table_name, table_comment

FROM

information_schema.tables

WHERE

table_schema = 'DB 이름' AND table_name = '테이블 이름';

왜 없을까 생각해보니 짚이는 점은 두 가지였다.

- custom backend가 제대로 동작(호출)되지 않았다.

- custom backend의 코드가 잘못되었다.

우선 1번의 가능성을 보기 위해서 새 모델에 임의의 필드를 추가하여 마이그레이션을 해보고, 그 상황에서 해당 custom backend의 코드가 호출되었는지를 디버거 등으로 살펴봐야 하겠다.

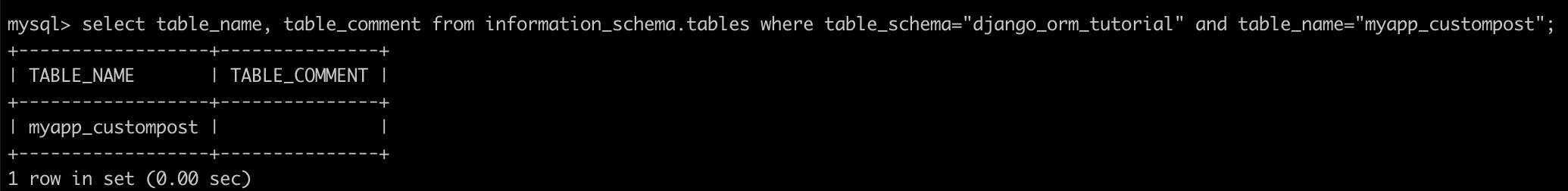

우선 myapp의 모델에서 변경 사항이 실행될 수 있도록 마이그레이션을 되돌려 보자(revert migrations). 해당 명령어를 실행하니 마이그레이션이 잘 되돌려졌다.

python manage.py migrate myapp 0004

마이그레이션을 한 단계 이전으로 되돌렸다. 이제는 다시 migrate 명령어를 실행해서 revert했다가 다시 실행하려는 그 migration이 잘 되는지를 테스트 할 차례인데, 그 전에 우선 custom backend에서 verbose_name 관련해서 새로 작성한 코드들에 전부 breakpoint를 걸어놓았다.

디버깅을 하다 보니 이상한 점이 있었다. custom_engine 디렉토리의 base.py 파일까지는 breakpoint에 걸리는데, 그 안에서 'SchemaEditorClass' 변수 값으로 정의한 CustomDatabaseSchemaEditor 클래스의 세부 메소드는 breakpoint에 걸리지 않았다. 이유가 무엇일까? 일단은 위에서 짚이는 방법 중 1번 원인이 유력해 보였다. 코드가 잘못된 게 아니라 호출되지 않아서 반영되지 않은 것 같았다. 하지만 왜일까.

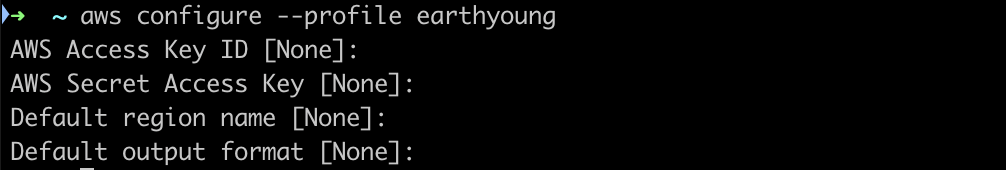

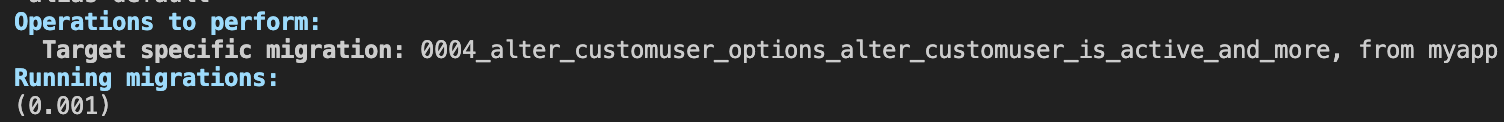

다른 방법으로 현재 모듈에서 backend engine으로 위에서 정의해 준 backend wrapper를 사용하고 있는지를 알아보았다.

python manage.py shellfrom django.db import connection

print(type(connection))

with connection.schema_editor() as editor:

print(type(editor))

그랬더니 이런 결과가 나왔다. 즉 CustomDatabaseSchemaEditor 클래스가 사용되지 않고 있었다. 이유가 무엇일까?

일단 여기서 막힌 상태이다. 좀 더 이유를 찾아봐야겠다...!!

✅ 과제 #1: 궁금한 점

- 왜 table에서 사용할 수 있는 'alter_db_table_comment' 메소드는 있는데 field에서 사용할 수 있는 전용 메소드를 따로 만들어 주지 않고 다른 방식으로 사용했을까?

- DatabaseWrapper는 왜 필요할까? Django는 왜 SchemaEditor를 그대로 사용하는 대신 DatabaseWrapper에 한번 더 감싸는 구조를 사용했을까?

'server-side > Django' 카테고리의 다른 글

| Django ORM 톺아보기 세션: 이해한 내용 정리하기 (1) | 2024.12.01 |

|---|---|

| django customizing user (0) | 2024.01.07 |

| django customizing authentication (0) | 2024.01.07 |

| django sessions (0) | 2024.01.06 |

| django migrations (0) | 2023.12.31 |